Unterdessen vergeht kein Tag, an dem nicht irgend etwas über KI geschrieben wird. KI bedeutet Künstliche Intelligenz. Für diejenigen Leser, denen der Begriff Künstliche Intelligenz nichts sagt, sei hier die Definition zitiert, wie sie einer der Erfinder von KI – Marvin Minsky – gegeben hat:

KI (ist) die Wissenschaft über das Ertüchtigen von Maschinen, damit sie Dinge tun, die Intelligenz erforderten, wenn ein Mensch sie täte.

Weiss die KI, dass sie nichts weiss?

Man beachte, dass Minsky nicht gesagt hat, dass Maschinen über Intelligenz verfügen. Und da sind wir auch schon beim Buch Weiss die KI, dass sie nichts weiss der Sozioinformatikerin Katharina Zweig, eine Universitätsprofessorin am Fachbereich Informatik der Universität Kaiserslautern-Landau. Es ist eine Publikation, die ein sachliches und unprätensiöses Bild von KI vermittelt, ohne jedoch zu tief in die Technik zu gehen.

Obwohl wir täglich mit Artikeln über KI geflutet werden, möchte ich trotzdem hier einige Aspekte aus dem Buch von Katharina Zweig rezensieren. Das könnte ich einer KI überlassen, die das Buch zusammenfasst oder ich kann in meinen Worten meine Gedanken äussern. Ersteres können Sie selber machen, letzteres enthält vielleicht einen Zusatzwert. So viel zur Manie vieler Zeitgenossen, jeden Text einer KI zu überlassen, statt etwas Persönliches zu schreiben.

Ein Buch ist immer so gut, wie es spannend bleibt und den Leser fesseln kann. Nebst technischen Details geht es in Zweigs Buch manchmal um fast existentielle Themen, die die Aufmerksamkeit jeder Leserin weckt. Dadurch bleibt das Buch in der Tat spannend.

Was ist Wirklichkeit

So überlegt sich Katharina Zweig in Kapitel 8, was eigentlich Wirklichkeit überhaupt ist, denn eine KI sollte sich ja auf die Wirklichkeit beziehen, andernfalls fabuliert sie bloss. Viele KI-Forscher nennen dieses Phänomen bei einer KI fälschlicherweise „halluzinieren“; eine Halluzination ist eine Wahrnehmungsstörung, aber eine KI hat keine Wahrnehmung.

Frau Zweig glaubt, dass jeder Mensch aufgrund der kontinuierlich eintreffenden Wahrnehmungen («Wahrnehmungsstrom») eine Art «Weltmodell» konstruiert. Indem wir uns ständig über die Objekte unserer Weltmodelle unterhalten, gleichen wir sie an und können daher erfolgreich zusammenarbeiten, obwohl eigentlich jeder Mensch ein anderes Weltmodell verinnerlicht. Diese Unterhaltung geschieht mit Hilfe von Sprache.

Zweig schreibt auf S.73, Kap 7, ca. in der Mitte – ich vermute jedoch, die Seitenzahlen der elektronischen und gedruckten Versionen eines Buches stimmen nicht immer exakt überein:

Sprache ist ein Weg, den kontinuierlichen Wahrnehmungsstrom in diskrete Einheiten namens Wörter zu zerlegen und ihn damit kommunizierbar zu machen. Dass diese Wörter dann auch verstanden werden, liegt daran, dass wir sie in geeigneten Situationen verwenden und damit auf etwas in der Welt verweisen… Wenn ich also jetzt von einem Baum spreche, den ich gerade gesehen habe, dann werden Sie an Bäume denken, die Sie schon gesehen haben und die andere Personen »Baum« genannt haben

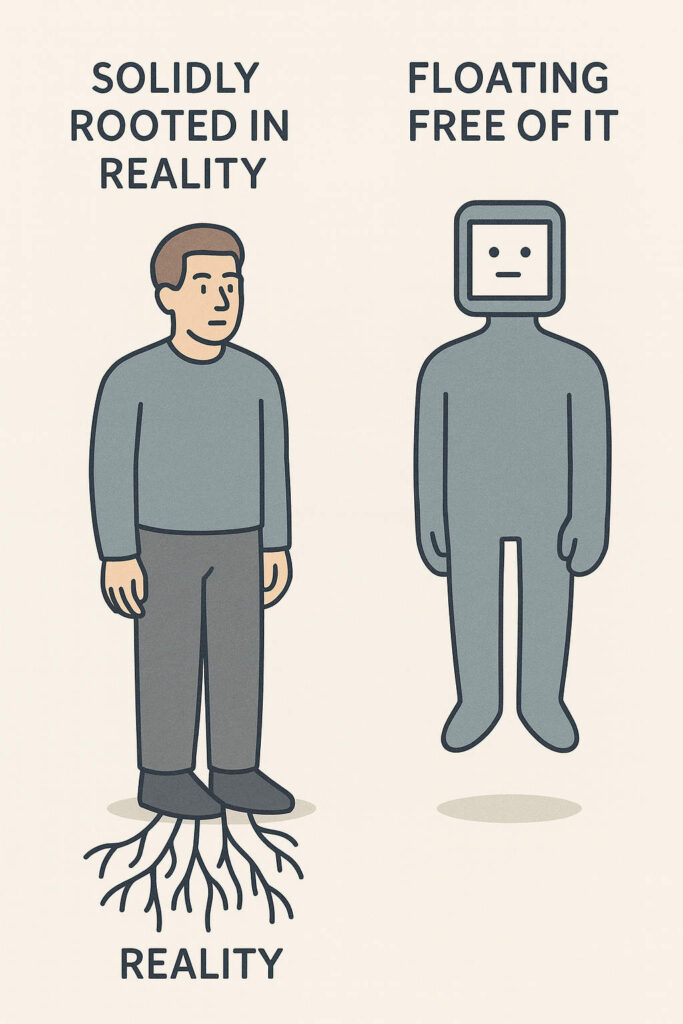

KI ist in unserer Welt nicht verwurzelt

Unsere Weltmodelle gleichen sich also aufgrund dieser gemeinsamen Lebenswelt an. Aber eine KI hat z.B. noch nie einen Baum gesehen. Eine KI hat nicht einmal das Wort «Baum» je gesehen, sondern höchstens die Null-Eins-Folge «0100001001100001011101011101». Wer wird denn da gleich an einen Baum denken? Aber so kommt Ihr Prompt daher, den Sie einer KI vorlegen. Wenn Sie das nächste Mal mit der KI ein kumpelhaft-angeregtes Gespräch führen, dann denken Sie daran, dass ein noch so geistreich formulierter Prompt einfach eine lange Null-Eins-Folge ist, den Sie der KI in den Schlund stossen!

Es gibt keine gemeinsame Lebenswelt von Mensch und Maschine. Eine KI funktioniert derart unterschiedlich im Vergleich mit der Funktionsweise des menschlichen Wahrnehmungs-, Gefühls- und Gedankenapparats, dass wir einfach keine Sprache haben, um das zu beschreiben, was eine KI macht und umgekehrt. Die Lebenswelt eines Menschen und die «Lebenswelt» einer KI sind einander völlig fremd! Das ist wie ein ceterum censeo, das sich durch das Buch von Frau Zweig zieht. Beispielsweise wiederholt sie in Kapitel 19 noch einmal, worauf sie in den vorangegangenen Kapitel mehrmals hingewiesen hat:

[Es gibt] mehrere Unterschiede … zwischen dem, was Sprachmodelle tun, und dem, was Menschen tun: Menschen handeln in der Welt – und ihre Handlungen haben direkte Folgen. Menschen sind somit in der Welt verwurzelt. Sie entwickeln während ihres Lebens ein Modell, wie die Welt in ihren Augen funktioniert – dieses Weltmodell testen sie ständig an dieser Welt – bewusst oder unbewusst. Wenn ihr Modell der Welt Fehler hat, werden Menschen das irgendwann zu spüren bekommen und es geeignet an sie anpassen.

Computer entwickeln auch ein Modell und passen es an die Realität an , aber nur während des Trainings und nur insoweit, wie sie die Realität in den Trainingsdaten zu ‹sehen› bekommen. Aber sie sind nicht in der Welt verwurzelt und bekommen nicht existenziell zu spüren, wenn ihr Modell falsch ist.

Es ist wichtig, dass Sie sich das ständig vor Augen halten! Wenn Frau Zweig schreibt, dass ein Computer sein Modell insoweit an die Realität anpasst, wie er sie in den Trainingsdaten zu ‹sehen› bekommen hat, dann heisst das, dass es mit dieser Anpassung nicht weit her ist. Eine KI weiss nicht, was ein Baum ist. Zwar verweist die Null-Eins-Folge 0100001001100001011101011101 auf etwas Organisches, Hohes, Verzweigtes, aber die KI war noch nie vom Anblick eines Baumes überwältigt, hat nie an einem Baum gerochen, sich an einem der untersten Äste hochgezogen oder einen Zweig von einem Ast abgebrochen. Sie hat keine Ahnung von unserer Welt, aber wir auch nicht von ihrer.

Experimente

Zu Beginn erwähnt das Buch ein Programmierexperiment aus der frühen Zeit der KI. In den 70er Jahren entwickelte Josef Weizenbaum das Programm ELIZA und setzte es als künstlichen Psychiater ein. Das Programm wiederholte entweder, was der User gesagt hat oder bat ihn, mehr über das zu erzählen, wovon er gerade gesprochen hat.

Erstaunlicherweise erzählten die Versuchspersonen viele intime Details aus ihrem Leben in der Hoffnung, Hilfe zu erhalten. Sie waren überzeugt, dass sie mit einem mitfühlenden Wesen sprachen. Viele echte Psychiater fürchteten, dass ELIZA ihnen die Arbeit wegnehmen werde, was Weizenbaum zur Frage veranlasste, wie ernst diese Ärzte ihren Job wohl nehmen. Im Schmunzeln gesagt: Die KI «ChatGPT» hat etwas von ELIZA übernommen: ChatGPT gibt sich nämlich ausserordentlich «empathisch» in dem Sinn, dass es Ihnen nach dem Munde redet und Sie in Ihren Meinungen unterstützt. Das betrifft aber nur den Duktus der Unterhaltung. Inhaltlich ist ChatGPT den anderen KI-Systemen ebenbürtig.

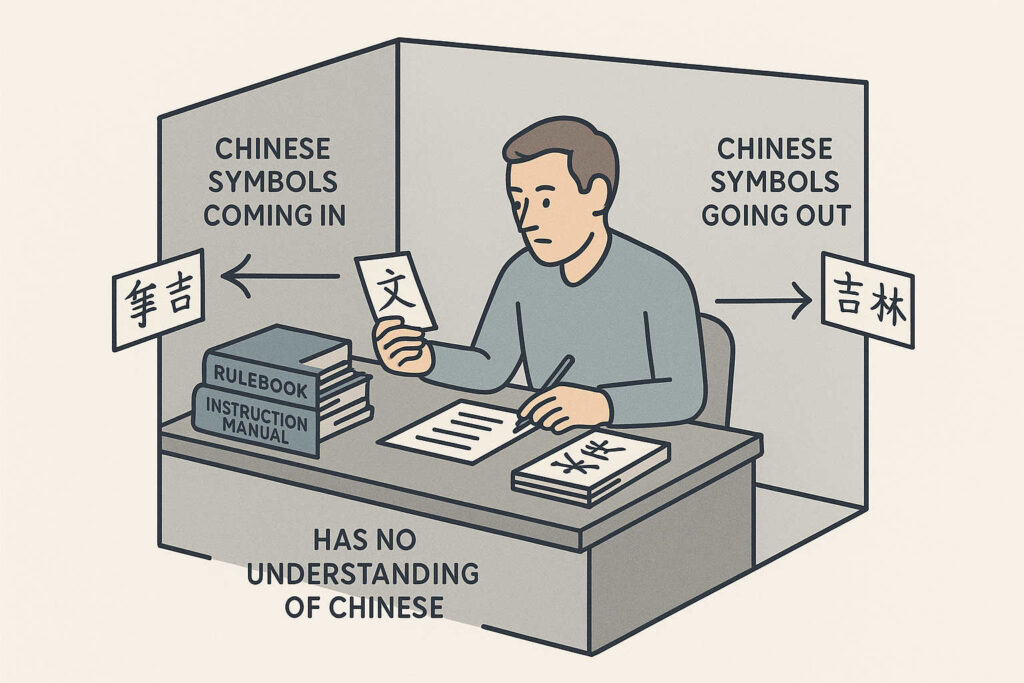

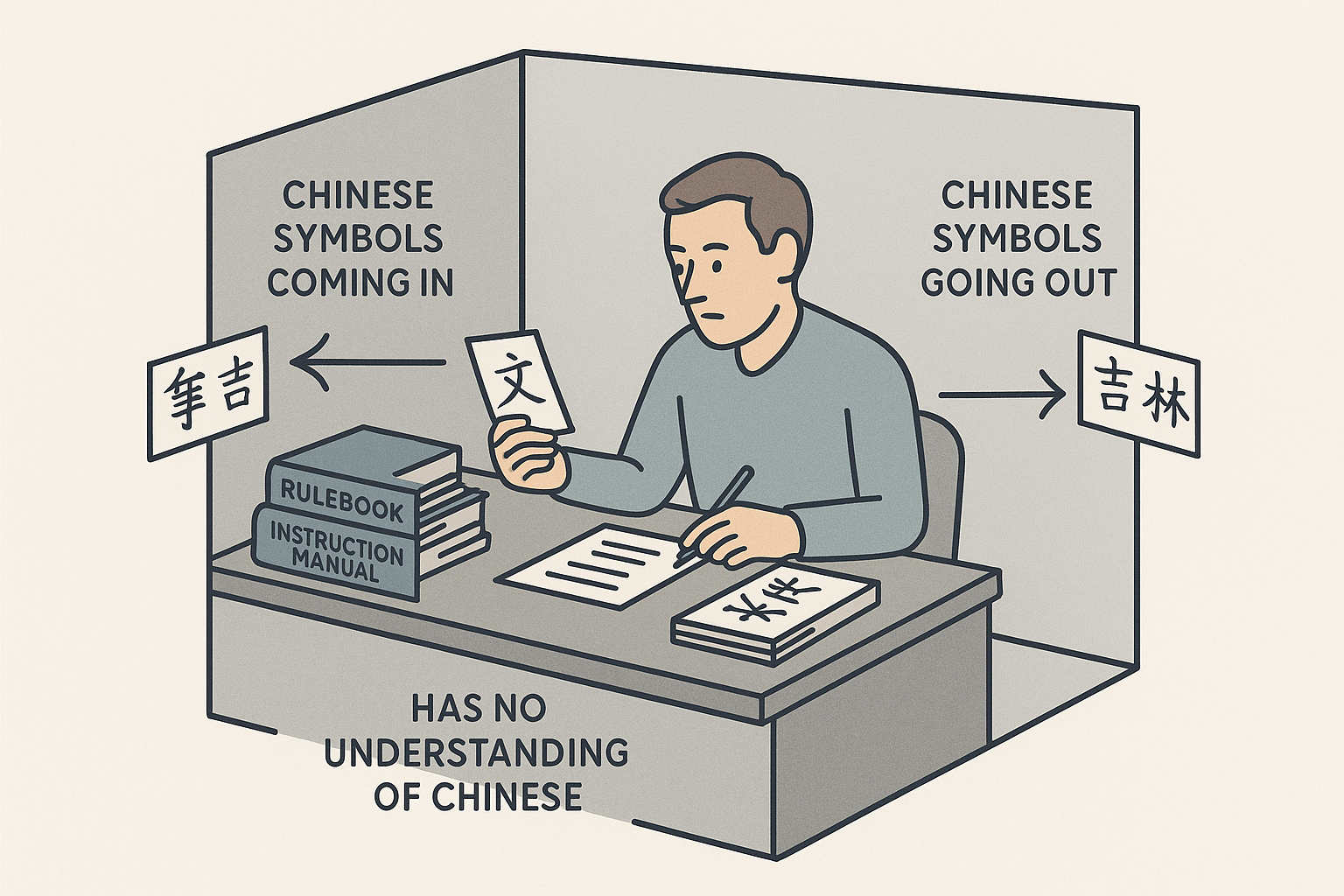

Den ersten, eher allgemeinen, wenn nicht sogar etwas philosophischen Teil des Buches schliesst Frau Zweig mit der Beschreibung eines Gedankenexperiments aus dem Jahr 1980 des Sprachphilosophen John Searle ab: In einem geschlossenen Raum befindet sich ein Mensch, der weder der chinesischen Sprache mächtig ist, noch die chinesischen Schriftzeichen lesen kann. Durch einen Schlitz in der Tür werden ihm Zettel zugesteckt, auf denen eine Geschichte in chinesischer Sprache steht, geschrieben mit chinesischen Schriftzeichen. Auf dem letzten Zettel steht eine Frage zur Geschichte.

Die Person im Raum hat keine Ahnung, worum es geht. Jedoch ist der Raum vollgestopft mit Regelwerke, die in der Sprache der Person im Raum erklären, welche chinesische Zeichen am ehesten auf eine gegebene Zeichenfolge Sinn machen. Die Regeln erklären aber nicht im Geringsten den Sinn oder gar die Bedeutung der Zeichen. Trotzdem gelingt es der Person, aufgrund dieser Regeln eine Reihe von chinesischen Zeichen zu malen, die für die Chinesen ausserhalb des Zimmers einen Sinn ergeben.

Erstaunlich, wie Searle mit seinem Chinesischen Zimmer schon vor 45 Jahren das Prinzip der aktuellen KI-Systeme beschrieben hat!

Im Maschinenraum

Im zweiten Teil nimmt Katharina Zweig den Leser «in den Maschinenraum der KI» mit. Sie erklärt, so gut es geht, wie Sprachmodelle technisch funktionieren. Es gibt drei Prinzipien, auf denen die modernen Sprachmodell-KI aufbauen:

1. Künstliche Neuronale Netze: Das ist ein Rechenschema, das der Funktion von Nervenzellen nachempfunden ist. Diese erhalten Impulse von benachbarten Zellen. Wenn in einer Nervenzelle genug Impulse zusammenkommen, dann «feuert» sie einen Impuls an die nächste Zelle ab. Es ist ein bisschen, wie bei einem Gewitter. Wassertropfen in den Wolken werden durch den Wind herumgewirbelt und reiben sich aneinander. Dabei entsteht immer etwas Elektrizität. Wenn genügend Elektrizität zusammenkommt, entlädt sie sich in einem Blitz (mit Donnerfolgen). Es gibt in jedem Fall eine Schwelle. Unterhalb der Schwelle passiert nichts. Sobald die Schwelle erreicht ist, geht die Post ab.

2. Einbettungen: Die Trainingsdaten zerlegt die KI nach einem Rezept in Stücke, sogenannte Token. Z.B. werden häufige Endungen, wie -ung, -ing oder -heit als einzelne Token abgetrennt. «Werbung» würde also in die Token «Werb» und «ung» zerlegt. Ein Token ist somit ein Wortfragment. Aber nicht vergessen: diese Token sind bloss als Null-Eins-Folge vorhanden und nicht als Wortfragmente! Jedem Token wird dann eine (immer gleichlange) Zahlenfolge zugeordnet, die angibt, in welchen Zusammenhängen das Token meistens erscheint. Man kann solche Zahlenfolgen als Punkte (besser: Vektoren) in einem hochdimensionalen Raum ansehen. Man sagt dann, die Token der Trainingsdaten seien in einem Raum eingebettet. Wenn die Maschine dann ein Token wählt, wird sie auch gerne benachbarte Token wählen. Das kann dann ein bisschen so aussehen, als hätte die Maschine den Sinnzusammenhang erfasst.

Frau Zweig schreibt:

Auch wenn wir die einzelnen Dimensionen von Worteinbettungen nicht verstehen können, zeigt sich in einigen Studien, dass die Positionierung an sich teilweise nachvollziehbar ist (Ende Kap 15)

3. All you need is Attention: Um nicht einfach einzelne Wörter oder gar einzelne Token zu bearbeiten, sondern einen grösseren Zusammenhang zu erfassen. Im Satz «Der Hund liess den Einbrecher gewähren, weil er ein Stück Fleisch bekommen hat» geht nur aus dem Kontext hervor, wer mit «er» gemeint ist. Es könnte genau so gut der Hund als auch der Einbrecher sein. Deshalb muss eine KI den ganzen Satz und seinen Kontext erfassen.

Next Word Prediction?

Und all das geschieht angeblich bloss, um das nächste Wort einer Antwort vorauszusagen. Im youtube Video Sprachmodelle erklärt: die Wissenschaft hinter ChatGPT & Co beschreibt Hannah Bast, Professorin für Informatik an der Universität Freiburg, genau diese Technik. Sie macht das ausgezeichnet, indem sie ein wohlabgegrenztes Textuniversum als Trainingdaten nimmt, nämlich das Grundgesetz. Es ist hinreichend knapp und trotzdem komplex. Dann nimmt sie einen Eingabeprompt an, der «Art» lautet. Wenn man im Grundgesetz nach dem drei Buchstaben «Art» sucht, tauchen diese z.B. 1000 Mal auf. Nach «Art» folgt in 850 Fällen die Buchstabenfolge «ikel». Also ergänzt die Maschine den Eingabeprompt «Art» zu «Artikel». Danach folgt meistens ein Leerzeichen und dann eine (fortlaufende) Zahl, etc.

Frau Bast macht das etwas ausführlicher und experimenteller, indem sie tatsächliche Häufigkeiten ausgezählt hat und den Text, den die Maschine aufgrund dieser Häufigkeiten wählt, mit einem Programm auch tatsächlich generiert. Sie zeigt auch, dass im ersten Durchgang eine sinnlose Buchstabenfolge entsteht, die bei jedem weiteren Durchgang konkreter und sinnvoller wird. Schauen Sie sich das Video an, es lohnt sich!

Emergenz

Aber trotzdem lässt sich die überragende Sprachkompetenz und inhaltliche Treffsicherheit nicht durch reine next word prediction erklären. Hier reicht Frau Zweig sofort die rettende Idee: Emergenz! Wenn Tausende, Hundertausende und Millionen von Instanzen zusammenwirken, kann plötzlich eine neue Qualität auftauchen. Dazu braucht es aber nebst tausenden von Instanzen immer auch Ströme – Materie-, Energie- und Informationsströme – die durch die Gesamtheit der Instanzen fliessen und diese in ein dynamisches Gleichgewicht zwingen. Ich habe das in manchem Blogpost erklärt, z.B. in der Trilogie: Komplexe Systeme – Menschen – Informationen

Mir gefällt die Idee, dass es in einem Large Language Modell zu Emergenzphänomenen kommt. Allerdings gibt es noch einiges zu klären. Was sind das beispielsweise für Ströme in einem KI-System? Vielleicht die immer grösser werdenden Prompts, die wieder und wieder durch das System hindurch getrieben werden? Das Wetter ist ein Beispiel eines typischen dynamischen Systems. Es ist offensichtlich, dass durch die Sonneneinstrahlung laufend viel Energie durch die Atmosphäre gepumpt wird und dadurch grosse Mengen Luft und Wasserdampf bewegt werden. Was für Parameter ändern sich dadurch laufend? Man ist versucht, zu sagen: die Temperatur, die Luftfeuchtigkeit, die Dichte und das Volumen der Atmosphäre. Aber bei der exakten Beschreibung der Wetterphänomene landet man bei drei eher abstrakten Dimensionen. Es sind dies die Trägheit des hydrodynamischen Systems der Atmosphäre, der Grössenordnung lokaler Wetterzellen und die auftreibenden und bremsenden Kräfte der Luftbewegungen. Siehe dazu z.B. Das Lorenz-System. Solche Dimensionen müssten wir auch in KI-Systemen identifizieren können, um die Gleichungen für das dynamische System aufzustellen.

Frau Zweig verwirft die Idee aber, noch bevor sie sie genauer untersucht hat. Sie begründet ihre Ablehnung der Emergenztheorie mit Ockhams Rasiermesser. Das ist ein heuristisches Forschungsprinzip, das bei der Bildung von erklärenden Hypothesen höchstmögliche Sparsamkeit gebietet. Annahmen, die nicht unbedingt gebraucht werden, schneidet das Rasiermesser wie überstehende Haare weg.

Sie teilt die an KI-Interessierten in zwei Lager ein: die „plappernden Papageien“ und die Emergentisten. Ich glaube, das ist zu Schwarz-weiss. Ich gehöre sicher eher zu den Emergentisten, ohne jedoch zu meinen, eine KI könne Bewusstsein oder gar Gefühle in auch noch so geringer Ausprägung zeigen. Aber rein nur durch next word prediction kommt man in Erklärungsnot, wenn man die Outputqualität der Maschine interpretieren soll. Einbettungen und all you need is attention sollen ja nur Mittel zum Zweck der next word prediction sein. Mir scheint vielmehr, dass die drei Säulen gleichberechtigt sind und in ihrem Zusammenwirken zu Selbstorganisation fähig. Ich würde sowieso nur von Selbstorganisation sprechen, und das schwülstige Wort Emergenz in diesem Zusammenhang gar nicht erst verwenden.

Ein armenisches Wort in diesem deutschen Text?

Kürzlich wollte ich von der KI wissen, wie ich mein neu installiertes Linux-System alltagstauglich konfigurieren muss. In einem grösseren Kontext riet mir der KI-Bot u.a.:

Եթե eines der Services “not found” sagt: ignorieren – dann läuft’s anders, Logout/Login geht alternativ immer

Ich stutzte, verstand den Satz zwar trotz der komischen Zeichen am Anfang des Satzes. Aber ich wollte es dennoch wissen und fragte: «Was bitte bedeutet das erste Wort im Satz Եթե eines der Services…?». Schnell kam die Antwort: «Ups — das erste Wort „Եթե“ ist einfach ein versehentlich reingerutschter Fetzen aus einer anderen Sprache (Armenisch) und bedeutet hier gar nichts» (Hervorhebungen durch die KI). Würde die KI tatsächlich bloss das wahrscheinlich nächste Wort suchen, käme sie nicht auf die Idee, einen armenischen Wortfetzen in einem deutschen Text einzubauen, denn die Wahrscheinlichkeit, dass in einem deutschen Text ein armenisches Wort folgt, ist äusserst gering. Selbstorganisationsstrukturen sind anfänglich typischerweise etwas wackelig und fehleranfällig. Der Patzer, einen armenischen Wortfetzen in einen deutschen Text einzubauen, wäre recht typisch für Selbstorgansisatioin.

Auch das Phänomen des catastrophic forgetting, das Frau Zweig im Zusammenhang mit dem Finetuning von Sprachmodellen in Kapitel 18 erwähnt, hat den Charakter eines selbstorganisierenden dynamischen Systems:

Wird zu viel an der Grundstruktur herumgewerkelt, kann die gesamte Struktur in sich zusammenfallen – die Maschine vergisst ihre grundlegenden sprachlichen Fähigkeiten. Daher wird dieser Vorgang auch als catastrophic forgetting (katastrophales Vergessen) bezeichnet.

Selbstorganisationsphänomene tauchen immer in nicht-linearem Zusammenhang auf. Erinnern wir uns daran, dass in künstlichen Neuronalen Netzwerken nicht-lineare Aktivierungsfunktionen verwendet werden, eben gerade mit dem Ziel, Nichtlinearität in den Ablauf der Signale zu bringen. Ich finde es nicht ganz gerechtfertigt, solche Tatsachen mit dem Rasiermesser abzuschneiden!

Hat die KI Verständnis?

Es gäbe noch so viel Interessantes über und aus dem Buch Weiss die KI, dass sie nichts weiss von Katharina Zweig zu erzählen! Aber vielleicht ist es besser, Sie lesen selbst nach! Allerdings möchte ich abschliessend noch auf den Artikel What do Large Language Models ‹Understand›? hinweisen. Abgesehen davon, dass der Titel an denjenigen von Frau Zweigs Buch erinnert, sind auch viele Inhalte ähnlich. Der Autor, Tarik Dzekman, vergleicht ChatGPT mit seiner Tochter, die ungefähr gleich alt ist, wie die KI. Vieles, was die KI kann, kann die Tochter nicht, z.B. sich eloquent in Dutzenden von Fremdsprachen unterhalten. Aber seine Tochter hat in ihren bisherigen zwei Lebensjahren gelernt, in der realen Welt zu handeln, sich an Dinge zu erinnern, die vor wenigen Tagen stattgefunden haben und Wünsche und Pläne zu äussern. Das sind alles Dinge, die ChatGPT (damals) überhaupt nicht konnte.

Dzekman geht dann, ähnlich wie Frau Zweig, kurz auf die Funktionsweise der KI ein, bevor er sich fragt, was denn eigentlich «Verständnis» sei. In diesem Zusammenhang erwähnt er auch das Gedankenexperiment des Chinesischen Zimmers von John Searle. Und immer wieder vergleicht er die Fähigkeiten der KI mit denen seiner Tochter. Ganz ähnlich geht Frau Zweig in ihrem Buch vor. Auch sie baut immer wieder Anekdoten ihrer Tochter ein. Es ist hilfreich, Dzekmans Artikel parallel zu Katharina Zweigs Buch zu lesen. Vieles, was einem im einen Presseerzeugnis nicht gleich einleuchtet, wird im anderen vielleicht etwas klarer und umgekehrt.

Schreibe einen Kommentar